L’intelligence artificielle, portée par des outils comme ChatGPT, redéfinit en profondeur les usages du web. Alors que certains y voient une avancée sans précédent, d'autres alertent sur les conséquences dramatiques pour les sites internet, les moteurs de recherche traditionnels et l’écosystème numérique dans son ensemble.

Le choc est déjà mesurable.

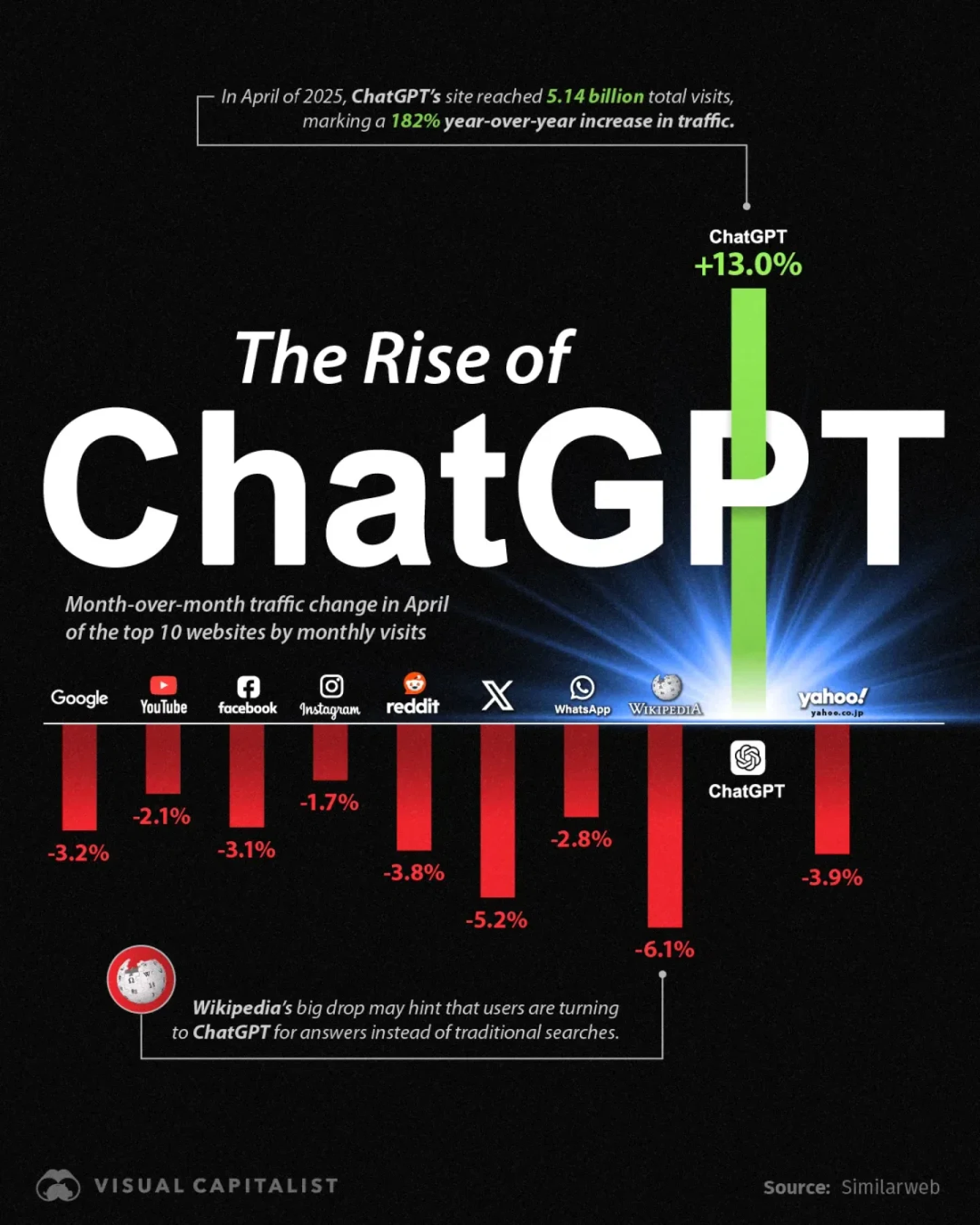

Le raz-de-marée ChatGPT : croissance fulgurante, pertes colossales

Depuis plusieurs mois, le web est secoué par l’irruption massive des IA génératives dans les usages quotidiens. ChatGPT, figure de proue de cette révolution technologique, enregistre une hausse de fréquentation de +13 %.

À l’inverse, les géants du web vacillent : Wikipédia accuse une chute de 6,1 %, Reddit perd 3,8 % de son audience et même Google s’essouffle avec une baisse de 3,2 %.

Ces chiffres témoignent d’un glissement irréversible : l'utilisateur se détourne des plateformes classiques pour s’en remettre à l’intelligence artificielle.

source visualcapitalist.com

Des éditeurs, indépendants en alerte face à une menace invisible mais réelle

L’onde de choc ne touche pas seulement les grandes plateformes : les éditeurs de contenu, les sites d’information, les entreprises, les e-commerçants et même les blogueurs indépendants constatent une érosion de leur visibilité.

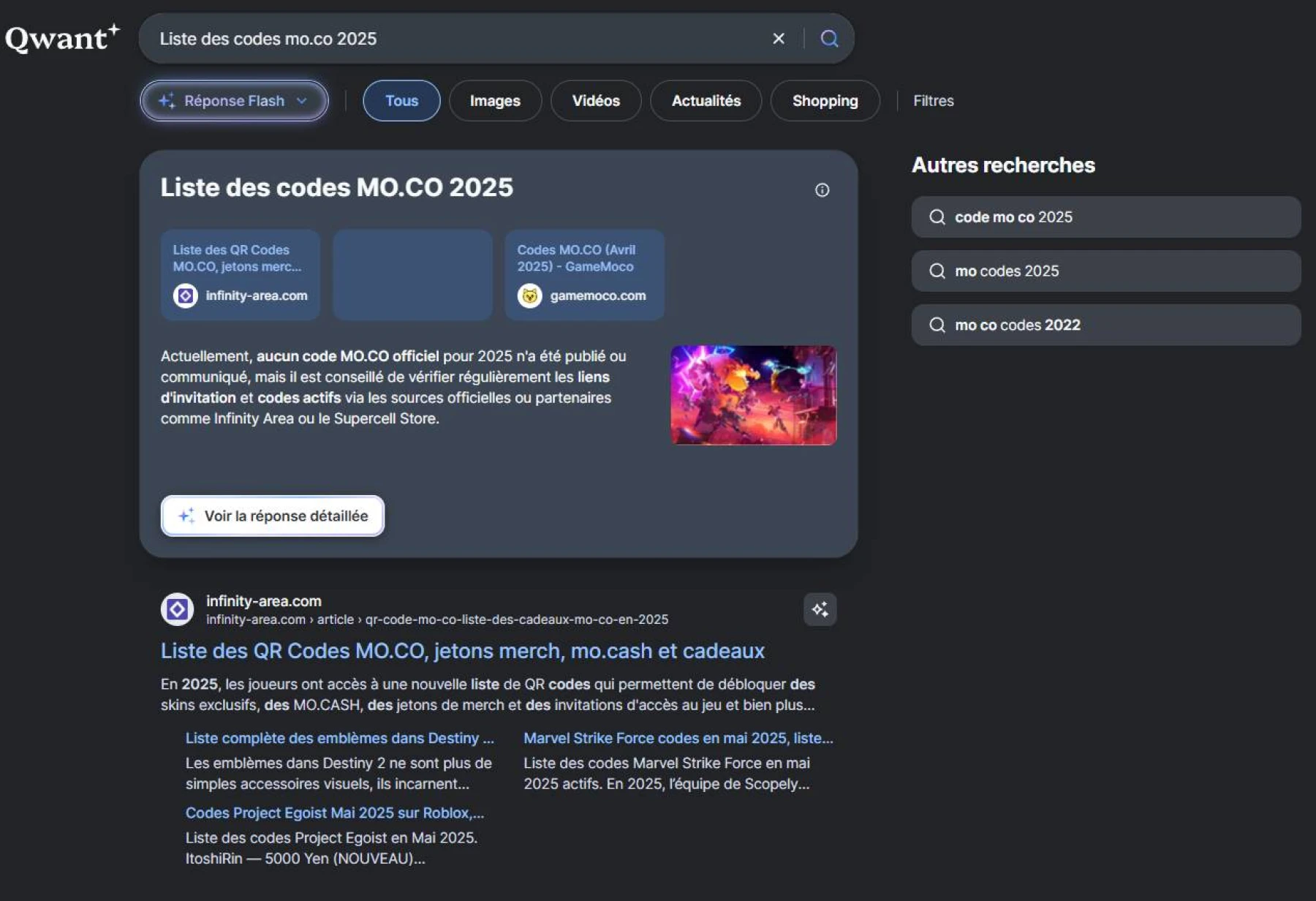

Les utilisateurs, désormais habitués à obtenir des réponses directes via des assistants IA comme Bing Copilot ou Qwant Next, ne visitent plus les pages sources.

Résultat : chute du trafic, perte de revenus publicitaires et fragilisation de l’économie numérique.

*Recherche sur Qwant

L’IA redéfinit les usages : vers la fin du web traditionnel ?

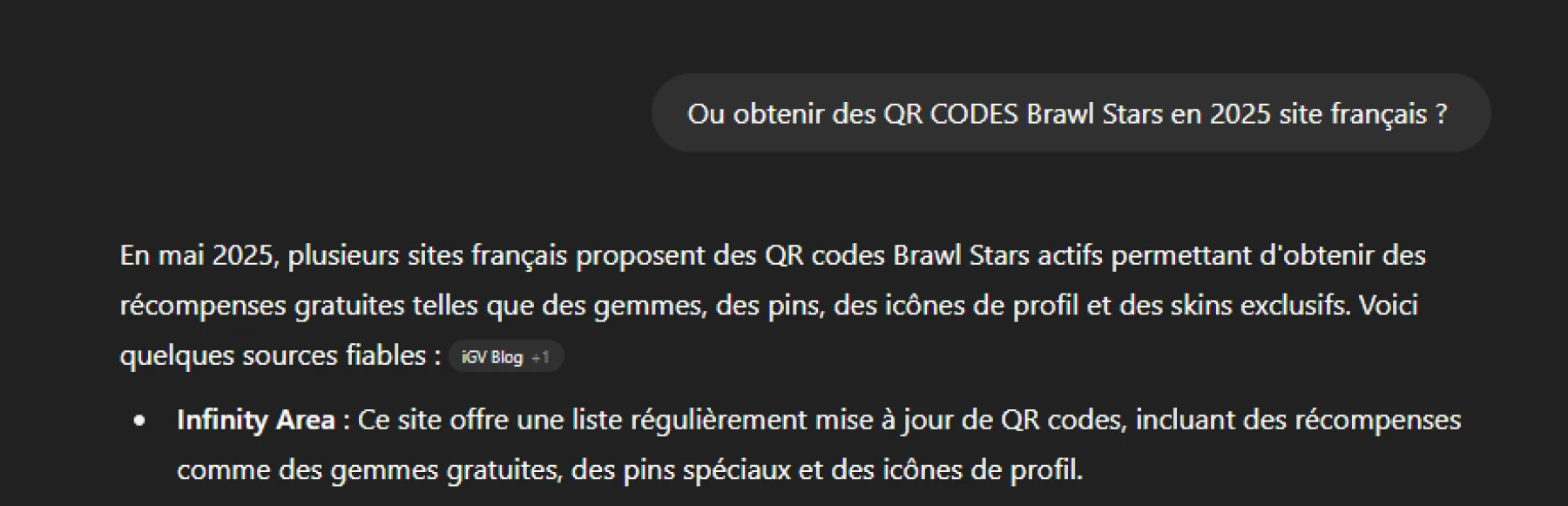

Ce n’est plus une supposition mais un constat : l’IA transforme en profondeur les comportements des internautes. L’accès à l’information devient conversationnel, instantané, personnalisé.

Google l’a bien compris et prépare l’arrivée de Gemini en Europe, son propre assistant IA qui pourrait encore creuser l’écart entre moteur de recherche classique et IA générative.

*Recherche sur ChatGPT

llms.txt : la riposte des créateurs face à l’ombre des LLM

Pour tenter d’exister face aux modèles IA, des solutions émergent. Le fichier llms.txt, analogue au robots.txt, propose un balisage destiné à guider les IA dans leur exploration des contenus en ligne.

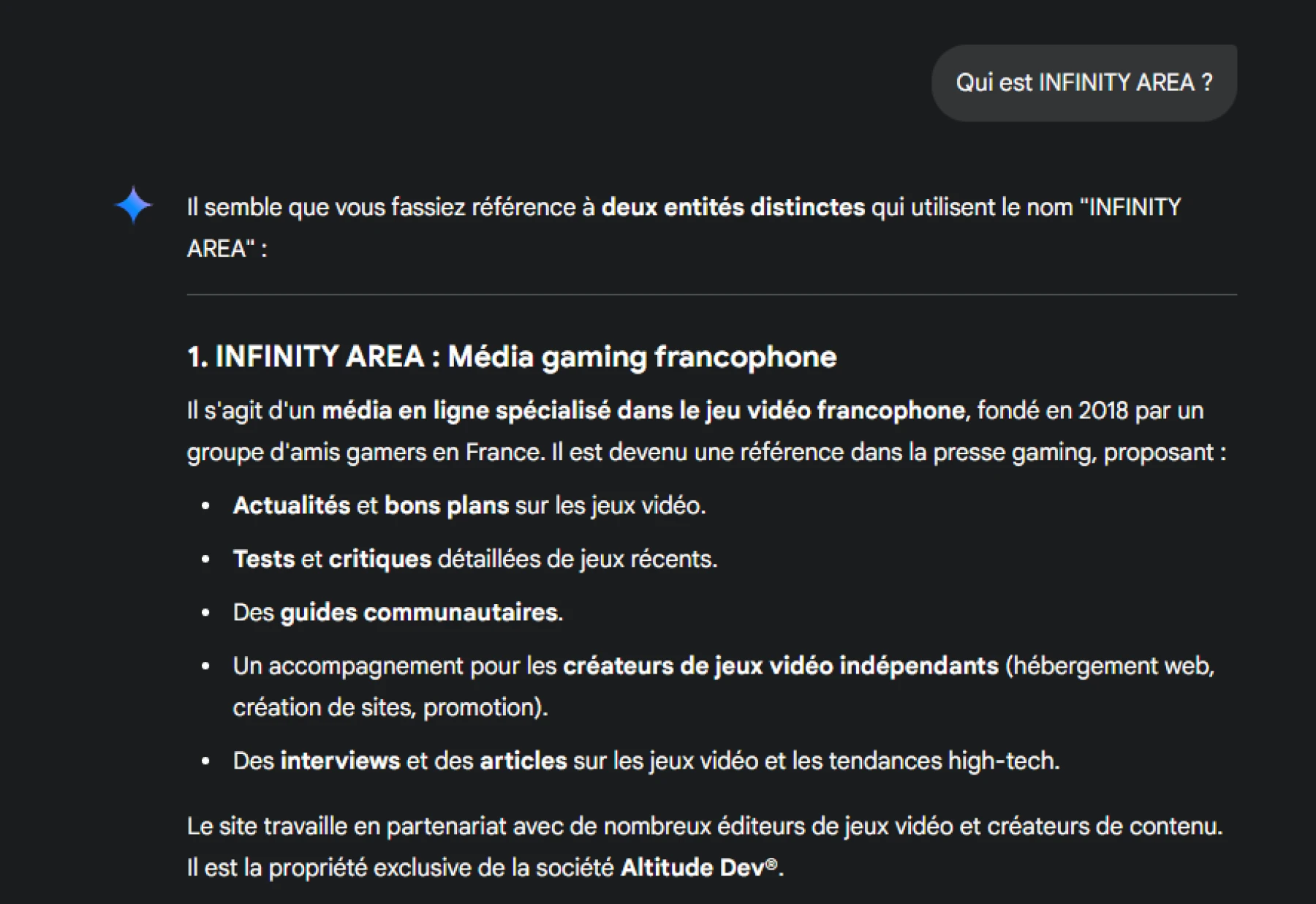

Des acteurs innovants comme INFINITY AREA ont déjà adopté cette stratégie pour préserver leur visibilité dans l’écosystème IA.

Objectif : baliser l’accès aux contenus, contrôler leur indexation, et (re)prendre le contrôle sur une nouvelle couche du web.

Des hébergeurs web et agences web françaises prennent le contre-pied de l’IA centralisée

Face à l’hégémonie des IA américaines, certains hébergeurs français se démarquent en déployant leurs propres moteurs d’intelligence artificielle sur des serveurs 100 % souverains.

Cette approche garantit une maîtrise totale des données et des performances, loin des géants du cloud. C’est le cas d’INFINITY AREA : hébergement privé en France, CMS français, agence web française, et en lien avec les développeurs de Qwant France.

Dans le même esprit, des agences web tricolores développent des outils comme Andromede CMS, un système de gestion de contenu pensé pour offrir une autonomie complète, sans dépendance à un écosystème étranger.

Une vision partagée par Qwant, futur navigateur européen engagé pour une IA éthique et indépendante, dont notre média a récemment eu l’opportunité d’interviewer les porteurs du projet.

*Recherche sur Gemini prochainement dans Google Search Europe

Quand l’intelligence artificielle fracture l’écosystème numérique

ChatGPT incarne une révolution technologique… mais aussi une menace silencieuse. Le web libre, ouvert, basé sur le lien, vacille face à un modèle conversationnel qui centralise, filtre et redistribue l’information à sa manière.

Dans cette transition brutale, les éditeurs n’ont plus le luxe d’attendre.

Pour survivre, il leur faut inventer une nouvelle manière d’exister face à cette IA qui, si elle ne tue pas le web, le reprogramme à petit feu.