Nvidia ne se contente plus de fournir les pelles aux chercheurs d'or, l'entreprise vend désormais les pépites. Avec le lancement de la famille de modèles Nemotron-3 8B, le géant vert bouscule l'échiquier de l'intelligence artificielle. Ces nouveaux modèles open source ne sont pas de simples alternatives, ils promettent une rapidité d'exécution foudroyante qui pourrait bien redéfinir les standards de production pour les entreprises.

Une puissance de calcul chirurgicale avec Nemotron-3

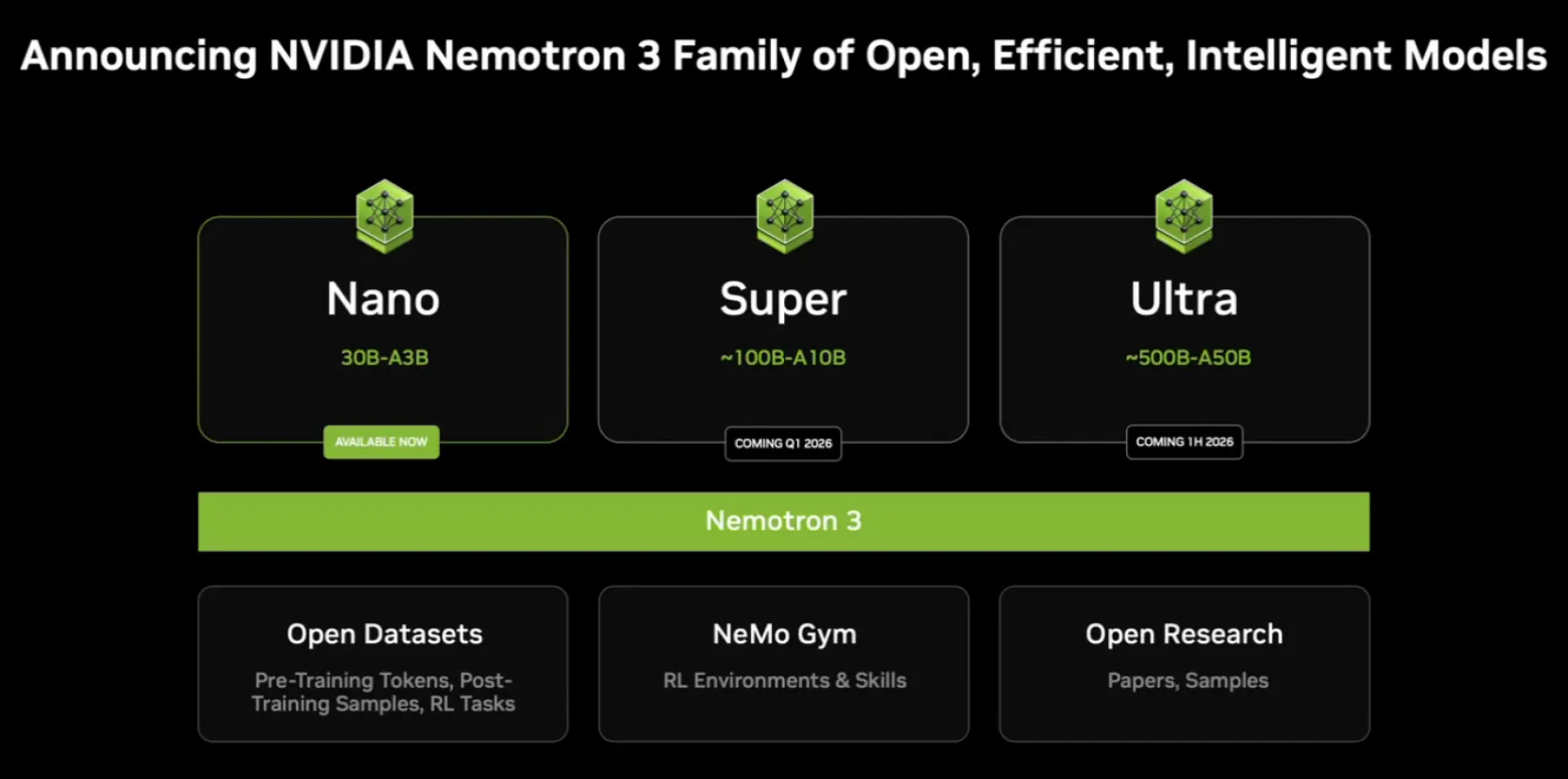

L'époque où la course à l'IA se résumait uniquement à un nombre astronomique de paramètres semble révolue. Avec Nemotron-3 8B, Nvidia prend le contre-pied des modèles gigantesques et énergivores.

L'objectif ici n'est pas de créer un chatbot omniscient pour le grand public, mais de fournir aux entreprises un outil d'une efficacité redoutable. Ce modèle de 8 milliards de paramètres a été conçu spécifiquement pour s'intégrer dans des environnements de production réels, là où la latence et le coût sont des facteurs critiques.

La véritable prouesse technique réside dans l'optimisation. En combinant ces modèles avec le framework TensorRT-LLM de Nvidia, les performances s'envolent. Les premiers benchmarks sont sans appel : Nemotron-3 est capable d'atteindre des vitesses d'inférence jusqu'à 4 fois supérieures à celles de ses concurrents directs, notamment le très populaire Llama 2 de Meta.

Pour une entreprise, cette différence ne se mesure pas seulement en millisecondes, mais en économies substantielles sur les coûts de cloud et de matériel. C'est la promesse d'une IA réactive, capable de traiter des requêtes complexes sans faire exploser la facture serveur.

Source Officielle NVIDIA

Quand le maître du hardware devient architecte logiciel

Ce lancement marque un tournant stratégique majeur pour la firme de Jensen Huang. Jusqu'à présent, Nvidia était le roi incontesté du matériel, fournissant les précieuses puces A100 et H100 qui alimentent ChatGPT et consorts.

En proposant ses propres modèles de fondation, l'entreprise franchit une étape supplémentaire vers une domination verticale du secteur. Elle ne se contente plus de propulser les logiciels des autres ; elle impose sa propre architecture logicielle.

La gamme Nemotron-3 se décline en plusieurs versions pour répondre à des besoins spécifiques : une version "Base" pour l'entraînement ultérieur, une version "Chat" pour les interactions conversationnelles, et une version "QA" (Question-Answering) optimisée pour l'extraction d'informations.

Cette segmentation prouve que Nvidia comprend parfaitement les besoins des développeurs. En proposant un écosystème clé en main, disponible sur Azure AI, Hugging Face et via son propre catalogue NGC, Nvidia s'assure que ses puces restent le support privilégié pour faire tourner ces IA.

C'est une stratégie de verrouillage par l'excellence : le logiciel est ouvert, mais il brille de mille feux uniquement sur le matériel maison.

Source Officielle NVIDIA

Une alternative taillée pour l'entreprise face à Meta

Le positionnement de Nemotron-3 est clair : il ne s'agit pas de jouer dans la cour de GPT-4, mais de dominer le segment des modèles de taille moyenne (autour de 7 à 13 milliards de paramètres), actuellement chassé gardée de Meta et de Mistral AI.

La force de la proposition de Nvidia réside dans la personnalisation. Grâce à la méthode SteerLM, les développeurs peuvent ajuster les attributs du modèle en temps réel lors de l'inférence.

Concrètement, cela signifie qu'une entreprise peut, sans réentraîner le modèle, demander à l'IA d'être plus concise, plus formelle ou plus créative selon le contexte. Cette flexibilité est le Saint Graal pour les intégrateurs de solutions logicielles. Là où Llama 2 nécessite souvent un travail de "fine-tuning" laborieux pour obtenir un comportement spécifique, Nemotron-3 offre une malléabilité native.

En saturant ce marché avec des modèles hautement performants et optimisés pour ses GPU, Nvidia s'assure que l'open source reste, paradoxalement, un moteur de vente pour ses solutions propriétaires.

L'avenir de l'IA se joue sur l'optimisation

L'arrivée de cette famille de modèles confirme que la bataille de l'intelligence artificielle générative se déplace du laboratoire vers l'usine. Ce n'est plus la taille du modèle qui compte, mais sa capacité à être déployé efficacement, partout, du cloud jusqu'aux serveurs locaux.

Avec Nemotron-3, Nvidia envoie un message fort : la performance brute du matériel ne suffit plus, c'est la symbiose parfaite entre le silicium et le code qui dictera les vainqueurs de demain.

0 commentaire